AIモデルGemmaとは?グーグルがオープンモデルで公開した理由

Googleでは。最先端のオープンモデルであるGemmaを2024年2月22日に発表しました。AIモデルであるGemmaはGoogle Couldで利用できるため、開発者にとって大きなメリットがあります。

Googleはこれまでクローズな環境で安全性を優先してきたのですが、今回はなぜオープンモデルで発表してきたのでしょう。この記事では、Gemmaの特徴や使い方と共に、GoogleがGemmaをオープンモデルで公開した理由を解説します。

- GemmaはGoogleが開発した新しいモデルである

- Gemmaはオープンモデルで公開されている

- GemmaによりAI開発がスムーズになる

Gemmaとは、Googleが発表した新しいAIモデルです。オープンソースであるため誰でも利用でき、AIアプリケーション開発に必要なツールを開発者に提供しています。Gemmaモデルは、Googleが開発した大規模言語モデルであるGeminiを基盤としており、AI開発コミュニティの拡大と発展が目的です。

Googleの広報担当者であるシェーンパークは、Gemmaは完全なオープンソースではなくオープンモデルであると説明しています。事前に訓練されているパラメータは利用できても、実際のソースコードでは訓練されたデータは使えません。

Gemmaは、様々な用途に活用できる軽量な生成AIモデルです。軽量であることからさまざまなデバイスで利用できます。また、オープンウェイトであることから自由にカスタマイズ可能です。

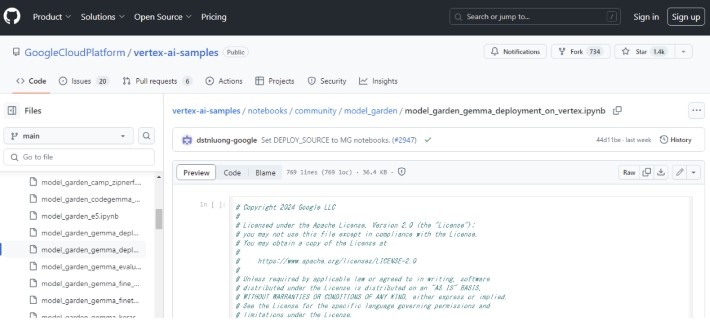

GemmaはGoogle Cloud PlatformのVertex AIやほかのツールで活用でき、AI開発をよりスムーズにできます。

Gemmaは、軽量モデルであることからアプリやハードウェア、モバイル端末、ホスト型サービスなど、幅広い環境で動作します。このため、モバイルアプリを使ったチャットボットや機械翻訳ツール、文章作成などさまざまな使い方が可能です。

Gemmaは、GoogleのAI原則を基準として作られています。Google Cloud Platform上のVertex AIと連携でき、本番環境にデプロイすることで実用的なアプリケーションとして活用できます。

動作状況を監視することでモデルの監視ができるため、AI開発をスムーズに進めることは可能です。また、Vertex AIはMLOpsに関連する知識がなくてもマネージドプラットフォームを提供することでMLプロジェクトの構築やスケーリングがスムーズにできるでしょう。

Vertex AIは、Gemmaモデルのあるダウンストリームアプリケーションとして活用できるため、さまざまな機能があります。例えば、ML機能に付加価値を加えることやMLOps 機能があることから、サーバーレスエクスペリエンスを提供しています。

これらのことから、Vertex AIを使ってAI開発をスムーズに進めることができるでしょう。

Gemmaモデルでは、Googleが自動化技術を採用したことから個人情報を削除しました。

GemmaはGoogle Couldで利用可能です。Gemimiモデルと同じインストラクチャコンポーネントを活用しています。

これらのことから、ほかのオープンモデルと比較しても高いパフォーマンスを発揮することが特徴です。

Gemmaは、Gemma2BとGemma7Bといった2種類のサイズウエイトがあります。

また、Gemmaは、Keras 3.0やKaggle Notebook、Hugging Face Transformers、JAXなどさまざまなツールをサポートしています。Google Couldの開発には必要なツールばかりであり、スムーズな開発が可能です。

Gemmaを使うためには、次のような手順で進めていきます。

- Vertex AIでGemmaを使う準備をする

- チューニングする

- デプロイする

Vertex AIでは、GemmaとCodeGemmmaといったモデルを使えます。

ほかにもDataflowやGoogle Kubernetes Engine、ColabなどといったGoogle Cloud プロダクトも活用可能です。

PEFTやKerasNLPなどを使ってGemmaをファインチューニングします。ファインチューニングとは、ニュートラルネットワークモデルを微調整することです。事前学習したモデルを再度トレーニングします。

チューニングが完了したらデプロイをすることでGemmaが使えるようになります。デプロイとは、GemmaをWebサーバー上に配置して利用できる状態にすることです。

ここでは、以下のようなGemmaについてよくある質問をまとめました。

- GemmaとCodeGemmaはどのように使い分ければいいですか

- VertexAI以外でもGemmaを使えますか

VertexAIではGemmaとCodeGemmaといった2種類のGemmaモデルを活用可能です。それぞれ特徴が異なり、ユースケースに合わせて使うモデルを選ぶとよいでしょう。

Gemmaはテキスト生成のほかに、抽出や要約に向いています。また、CodeGemmaはコードの生成や補完をする際に利用できます。利用する際は必要なモデルをモデルカードに移動してください。

VertexAI以外でも、DataflowやGoogle Kubernetes Engine、ColabといったGoogle Couldプロダクトでも利用できます。

Google Kubernetes Engineは、セキュリティや拡張性などに優れています。またDataflowはGemmaモデルを使った推論パイプラインを実行することで感情分析ができる点が特徴です。Colabはソリューションを作成できるほかJAXやPyTorchなどのフレームワークオプションも利用できます。

Gemmaは、軽量モデルでありGoogleクラウドで利用できるオープンモデルです。これまでクローズドな環境を展開していたGoogleとしては異例のモデルですが、実際のソースコードや訓練データは利用できません。しかし、事前に訓練されたパラメータを活用できることから、AI開発者にとって開発工程をよりスムーズにできるでしょう。

関連記事

TEXT:PreBell編集部

PHOTO:iStock

この記事を気にいったらいいね!しよう

PreBellの最新の話題をお届けします。