Meta Platforms、AI機械学習によるアプリケーション「Image Decoder」を発表

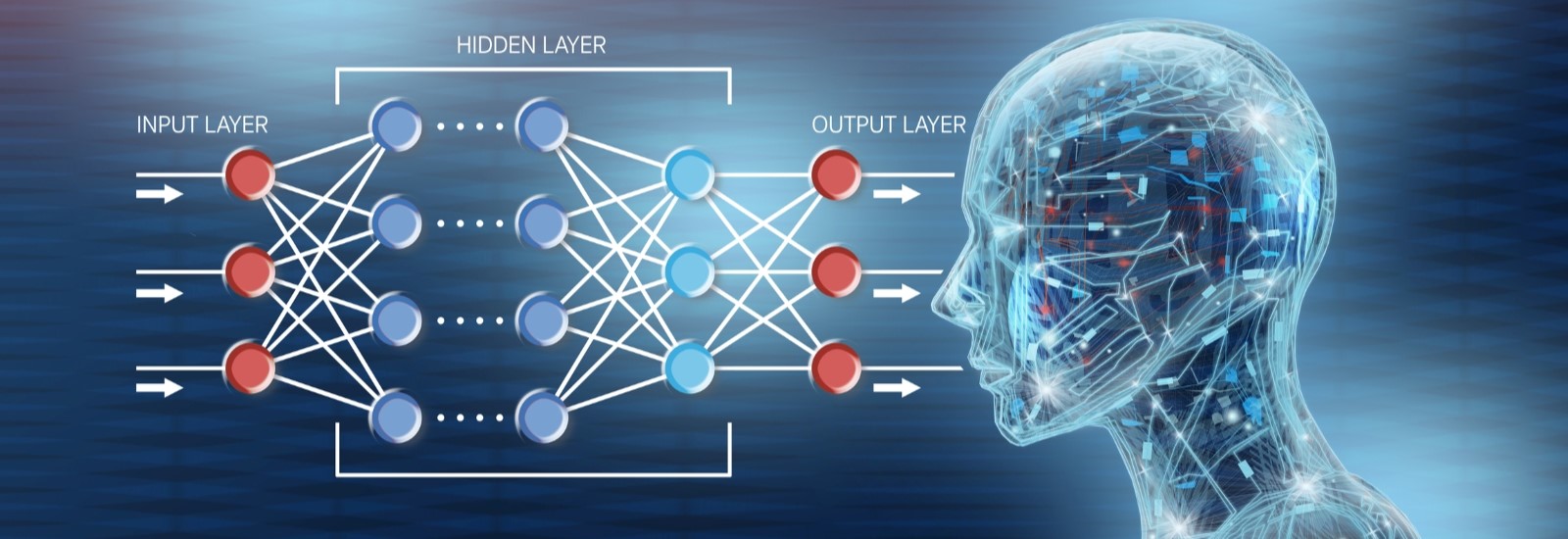

Meta Platformsの研究者は、MetaのCVタスクの基盤モデル「DINOv2」をベースにしたディープラーニングによるアプリケーション「Image Decoder」を発表した。

これはAIの機械学習の1つである。このアプリケーションを使えば、被験者の脳活動に基づいて何を見ているか、何を想像しているかを見ることができるという。

DINOv2は、他のモデルを学習させるために設計された自己教師付き学習モデルであり、北米の森林の風景を学習させている。Meta研究者たちはImage Decoderのアルゴリズムに、生データと脳がMEG(Magneto-Encephalo-Graphy)活動を起こしたときにその人が実際に見ていたもののデータの両方がわかるように指示した。

このようにして、アルゴリズムは特定の色や形が脳内でどのように表現されているかを解読した。Image Decoderは、潜在的なイメージのプールから画像を取り出すことに成功したが、より複雑で多様なイメージの解読はできなかった。

Metaは、人間の知能の基礎を理解し、AI システムを構築するための長期的な研究イニシアチブを強化することを目指している。

現実の世界にデジタルな物体を重ねる、Meta Quest 3

Image Decoderの技術が進歩すれば、私たちはメタバースでの体験をより豊かにする可能性があると考えられる。実際、最近Metaは新しいVR/MRヘッドセット「Meta Quest 3」を発表した。

このヘッドセットは7万円台から購入することができる。これを装着することで、現実の世界にデジタルな物体を重ねる表現が可能になる。このような新しい技術の導入によって、私たちはますます没入感のあるメタバースの世界を体験することができるだろう。

【関連リンク】

・脳活動からの画像のリアルタイム解読に向けて(Meta)

https://ai.meta.com/blog/brain-ai-image-decoding-meg-magnetoencephalography/

TEXT:PreBell編集部

PHOTO:iStock

この記事を気にいったらいいね!しよう

PreBellの最新の話題をお届けします。